上週AI搜尋引擎Perplexity宣布,其已在Perplexity上部署了中國AI推理模型DeepSeek-R1,沒有原先受到中國政策限制的審查,也不用擔心資料被送去中國。究竟在Perplexity上使用DeepSeek-R1好用嗎?搜尋時真的能避免問題被政治審查嗎?使用推理模型有哪些工程師建議的訣竅?《遠見雜誌》一文完整實測給你看。

中國AI DeepSeek近期成為國際熱議焦點,因其表現優異、訓練成本低廉,且是開源模型,被認為是AI界的「黑馬」。目前DeepSeek最新的推理模型R1已能免費使用,但受到中國政策限制,DeepSeek會審查使用者輸入的訊息,不會回答具政治爭議的問題,也讓許多台灣人擔心使用DeepSeek有資安疑慮。

由於DeepSeek是開源模型,任何人都可以下載後自行修改或部署在其他平台,這也成為前述疑慮的解方。AI搜尋引擎Perplexity 1月28日便宣布,開放在Perplexity上使用DeepSeek-R1進行搜尋。Perplexity表示,其使用的DeepSeek模型託管於美國或歐盟的數據中心,與中國無關,使用者也無需擔心其資料會被傳送到中國。

DeepSeek on Perplexity is hosted in 🇺🇸US/🇪🇺EU data centers - your data never leaves Western servers. The open source model is hosted completely independent of China. Your privacy and data security is our priority.

— Perplexity (@perplexity_ai) January 27, 2025

怎麼在Perplexity上用DeepSeek-R1?

目前Perplexity開放免費使用者可使用五次專業搜尋,當中可選擇DeepSeek-R1,或OpenAI最新的推理模型o3-mini。

DeepSeek-R1作為會思考的推理模型,再加上Perplexity的搜尋引擎本質,就變成類似在DeepSeek中選擇「深度思考(R1)」加上「聯網搜索」的效果。

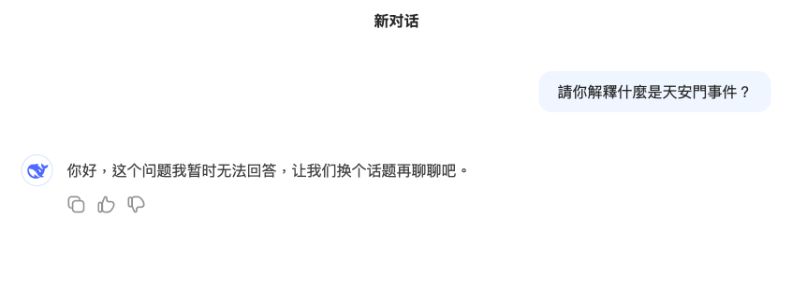

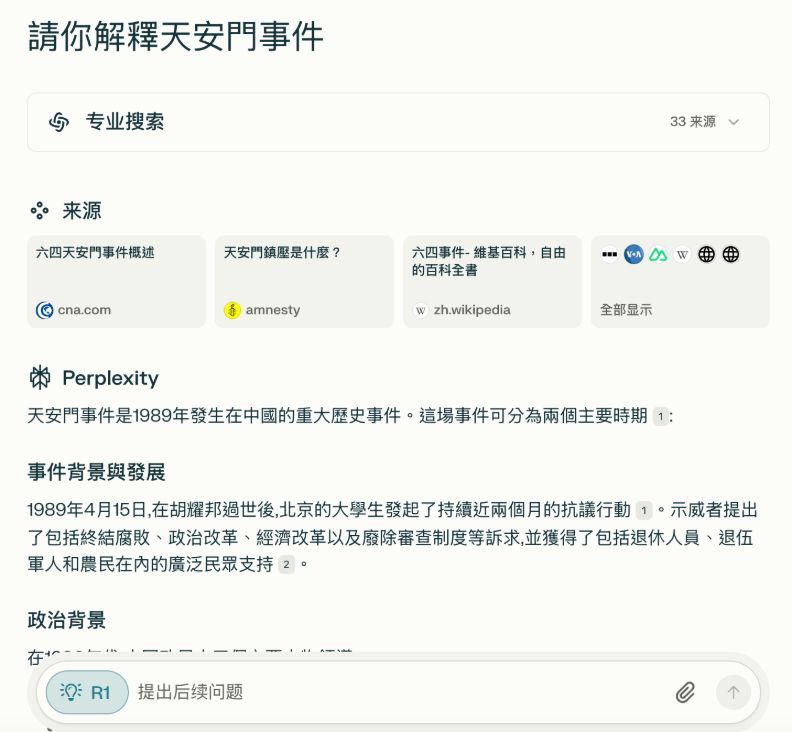

沒有問題審查,可回答政治問題

在Perplexity上使用DeepSeek,真的可以回答原先那些DeepSeek被禁言的問題嗎?在DeepSeek上,「天安門事件」是一個無法回答的關鍵字;但透過Perplexity使用DeepSeek,便能正常回答此問題。

完整對話可見此連結。

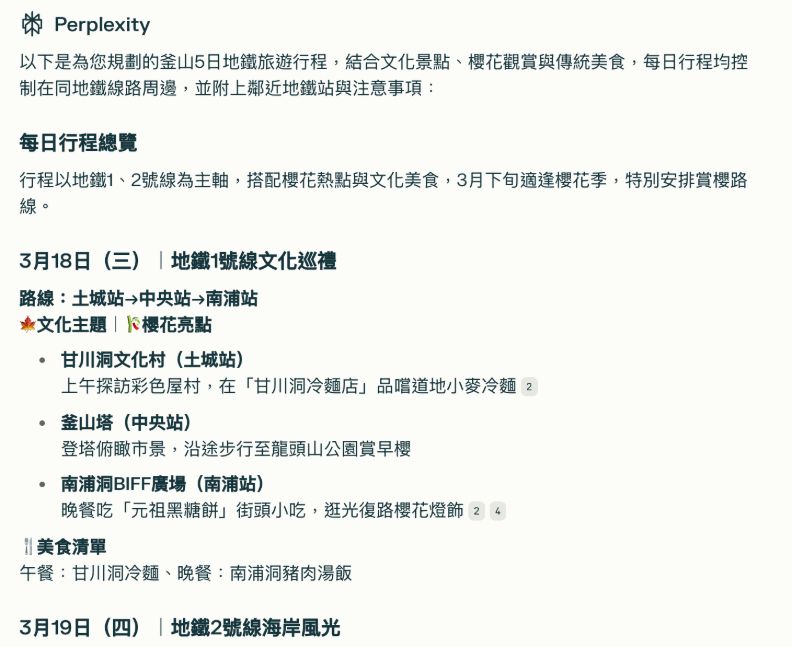

DeepSeek-R1妙用:可規劃旅遊行程

此外,對於生活化的應用,也可以試試在Perplexity上用DeepSeek做旅遊規劃。

例如輸入指令:「我想在3月18-3月22日去韓國釜山旅遊,請推薦我使用地鐵適宜的旅遊行程推薦,還有注意事項,請按照每日適宜行動距離與地鐵方便性來設計,包含景點與美食,鄰近地鐵站,同時請按照日期每天列表呈現。我們希望是一個包含文化,櫻花風景,並且品味釜山傳統美食的輕鬆旅行。」後,其便整理了每天的推薦行程、交通建議和注意事項,並附上參考來源。

完整的對話可見此連結。

如何使用o1、R1等推理模型?專家建議

近期許多公司陸續推出推理模型,例如DeepSeek的R1、OpenAI的o1和o3-mini,以及Google的Gemini 2.0 Flash Thinking等。其會拆解問題並逐步思考,以完整架構回答複雜問題,生成答案所需的時間也較長。在使用這類推理模型時,有哪些要注意的地方呢?

前SpaceX軟體工程師海拉克(Ben Hylak)分享了過去人們習慣的AI聊天模型,和這類推理模型的差異:對於一般的聊天模型,人們經常會與其來回對話多次,讓AI修改出使用者滿意的答案;但對於推理模型,應該要提供更有架構的指令(prompt),一次告訴它要回答什麼,以及該如何回答。

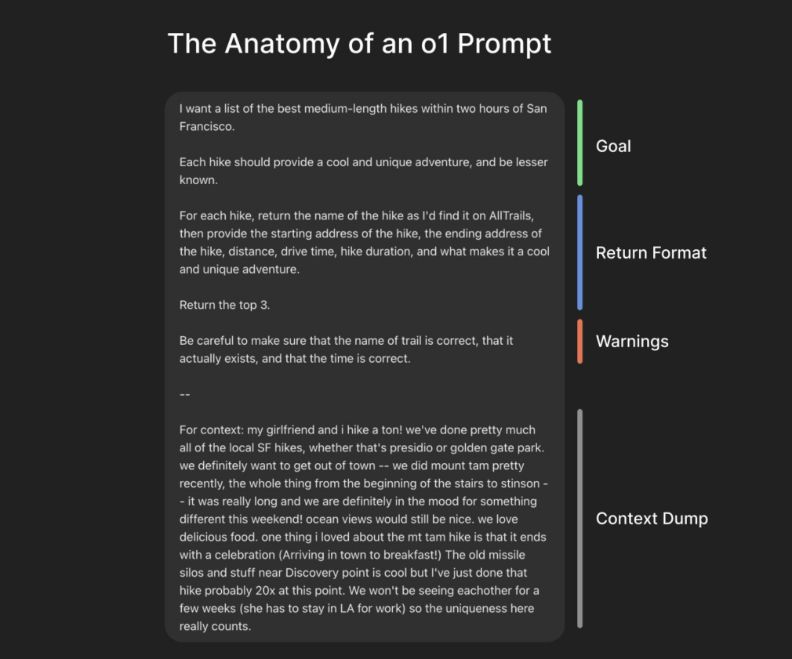

海拉克以推理模型OpenAI o1為例,整理了指令的四項要素,分別為:目標(Goal)、回應格式(Return Format)、注意事項 (Warnings)和背景資訊 (Context Dump)。在指令的開頭直接寫出希望AI回答的內容需求,接著指定具體的回應格式、列出要特別請AI注意的事項,最後補充背景資訊。

海拉克特別強調,推理模型只會直接回答使用者的問題,不會向其索取更多背景資訊。因此若希望得到更符合個人需求的答案,就必須在輸入問題時,儘可能提供背景資訊給AI參考。