邊緣運算(Edge Computing)是什麼?為何微軟、蘋果、NVIDIA都重兵布局?《遠見》從資安、延遲、小模型(SLM)等角度,採訪多位專家,完整解析邊緣運算的商業潛力、硬體限制與未來趨勢,助您掌握下個科技浪潮。

邊緣運算是什麼?

所謂邊緣運算(edge computing),亦可稱作邊緣AI(edge AI)或裝置端AI(on-device AI),核心概念是將人工智慧的運算任務,從遙遠的雲端資料中心,轉移至更貼近使用者的終端裝置上執行。

此模式與雲端運算(cloud computing)形成鮮明對比。它強調在資料生成的網絡「邊緣」地帶即時處理,無需將數據遠程傳輸至雲端。

以大家熟悉的ChatGPT為例,使用者無論選擇GPT-4o或GPT-5模型進行對話,其背後的AI推論(inference)工作,全數在雲端伺服器完成。

相對地,企業端(B2B)應用可將AI模型直接部署於工業電腦或特定設備中,實現地端(on-premises)自主運作。而在消費端(B2C)市場,微軟、英特爾高舉的AI PC大旗,以及蘋果、三星等手機巨頭力推的AI手機,其核心賣點正是在裝置上直接運行AI功能。

從市場數據來看,邊緣運算在企業與消費市場均蘊藏巨大商機。市調機構IDC預測,全球邊緣運算解決方案支出將在2025年達到2610億美元,並於2028年攀升至3800億美元,年均複合成長率高達13.8%。

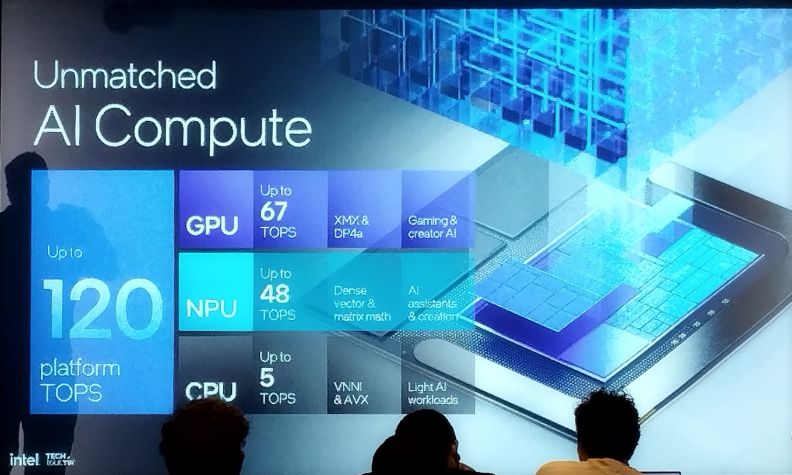

資策會也預估,具備超過40 TOPS(每秒兆次運算)算力的AI PC,以及內建AI晶片的智慧型手機,未來三年的市場滲透率將顯著提升。

聚焦智慧型手機市場,尼爾森愛科分析指出,裝置端AI是驅動今年換機潮的關鍵動力之一。其供應鏈與產業分析客戶成功總監李宗諺表示,2024年全球手機終端需求預估由11.64億台微幅成長至11.81億台,其中搭載AI處理器的手機出貨量將從去年的1.58億台(占比14%)大幅躍升至2.21億台(占比20%),成長趨勢明確。

事實上,剛才結束的SEMICON Taiwan 2025 國際半導體展上,恩智浦半導體執行長西佛斯(Kurt Sievers)便強調,AI不只在雲端上運行,倘若想要進入實體世界,便要透過邊緣應用才能實現。

邊緣運算為何重要?有哪些適合場景?

既然雲端的ChatGPT、Claude已能順暢運行,為何還需要邊緣運算?原因在於,雲端運算並非無所不能。

陽明交通大學電機系特聘教授黃俊達分析,驅動AI從雲端走向地端的兩大核心動力,分別是降低回應延遲(latency),以及保障資訊安全及隱私。

低延遲需求:反應速度攸關成敗

就回應速度(response time)而言,一般使用者與Gemini或Claude進行文字互動時,或許不易察覺延遲。然而,一旦任務趨於複雜、消耗的符元(token,可理解為AI處理語言的基本單位)數量劇增,模型的回應效率便會出現明顯落差。

這裡的回應速度,不僅指和AI對話時等候多久,更泛指AI從接收指令或感知環境變化,到做出反應所需的全部時間。

例如,自動駕駛系統能否在毫秒間判斷路況、安防攝影機是否能即時識別異常行為、工業產線能否在生產過程中迅速找出瑕疵,在這些應用情境中,反應速度的快慢直接決定了產品的優劣。

黃俊達以今年4月ChatGPT免費開放圖片生成功能,引爆「吉卜力」風格頭像熱潮舉例,當時大量用戶湧入導致OpenAI伺服器不堪重負,執行長奧特曼(Sam Altman)甚至在社群媒體上坦承GPU算力耗盡,被迫限制免費用戶的生成額度。

可以想見,未來若小模型(SLM)成熟,搭配效能更強的AI晶片,消費者將能直接在個人電腦或手機上生成圖像,無需在螢幕前苦苦等候,待雲端資料中心處理完畢再回傳結果。

犀動智能創辦人沈書緯補充道,儘管雲端AI模型的回應速度也在持續改進,但若有應用場景選擇邊緣AI,通常意味著它對延遲極度敏感。「像是車用場景,就屬於『性命攸關』(critical)等級,」這與一般對話應用的即時性要求截然不同。

消費者可以選擇加價,享受高品質、低延遲的服務,但是對企業來說,雲端運算成本高昂,若預算不足而影響服務速度,帶來影響很大。因此,部分企業轉而尋求地端方案。

「如果建在地端,關在企業內部,就不會發生類似這樣的事情,」黃俊達解釋。

資安與隱私:企業不敢上雲

除了追求即時反應,對隱私的高度重視也是企業擁抱裝置端AI的關鍵原因。

例如,醫療機構、銀行及高科技製造業等企業,因其資料的機敏性,許多場域甚至禁止連接外部網路,對資料上雲本就設有嚴格規範。將AI運算留在邊緣裝置,正是出於資安考量。

前Google台灣董事總經理簡立峰分析,對於擁有敏感資料的企業而言,採用地端運算方案,不僅能避免資料上傳雲端伺服器的風險,更能安心地對微調模型,從而掌握更高的自主權。他認為,無論從動機或應用場景來看,企業級的邊緣運算發展已日趨成熟。

西佛斯總結,不用擔心資料傳輸頻寬(bandwith)受限、關鍵應用需要即時性(real-time)、要求能源效率(energy effieciency)、追求結合安全和資安的信任(trust),這四大原因是AI進入實體世界,例如汽車、工廠、農地等場景時,邊緣AI能夠發揮的優勢。

邊緣運算有何發展動能?有什麼應用案例?

若要探究推動邊緣運算發展的催化劑,小語言模型(small language model,SLM)的進步,無疑是其中最值得關注的趨勢。

小語言模型:讓邊緣運算成為可能

包括微軟、Meta、Google等科技巨頭,以及Mistral、OpenAI等新創公司,在遵循「擴展定律」(scaling law)持續打造大模型的同時,也紛紛釋出參數規模介於數億至數十億之間的小型模型。

APMIC創辦人暨執行長、Google開發者專家(GDE)吳柏翰觀察,在阿里巴巴、NVIDIA、OpenAI及Google等巨頭競逐的開放模型(open weight model)戰場中,「有超過一半都在轉往SLM的發展」。

除了成本考量以外,吳柏翰引述NVIDIA今年發表的研究論文,表示企業應用語言模型時,因為缺乏內部知識,倘若想要部署AI Agent,「有70%都要小模型去優化,才能讓Agent使用。」

不管是透過蒸餾(distillation)或者剪枝(pruning)等技術,在減少模型參數量以後,雖然小模型的通用能力不及大模型,卻有辦法在特定領域展現出相當優異的表現。

黃俊達強調,小模型的蓬勃發展鼓舞邊緣運算,未來僅需筆電或手機等級的運算資源,便能順暢運行語言模型,為企業和消費者開啟了廣闊的應用前景。

「原來的大語言模型被要求上知天文,下知地理,因為訓練資料什麼都有,但可能沒有一樣真的專精。」黃俊達解釋,企業在實際應用中,可以開發針對特定領域(domain specific)的小模型,例如專為公部門客服或輔助醫生查詢病歷而設計的模型。

在消費端應用,也能看到筆電與手機品牌廠正積極推出AI新功能,例如微軟用於搜尋電腦操作紀錄的「回顧」(Recall)功能,或是蘋果遲未現身的Apple Intelligence,以及Google號稱相機鏡頭達到百倍變焦的Pixel 10。

黃俊達點出了技術面的驅動力,而從產業應用角度,前Google台灣董事總經理簡立峰則看到了企業端更迫切的需求。

他指出,由於模型規模縮小、能力降級,所以要尋找專門(specialized)應用,例如企業有明確細分場景,就會需要客製化模型,這時小模型便有機會派上用場。

他舉例,台灣一家積極拓展海外市場的高科技製造商,就開發了一款能在手機上運行的SLM,並用產業專有知識和術語進行訓練,成為員工隨身的即時翻譯利器。

「只要硬體規格跟上,Edge端的應用場景遠比想像中豐富,各行各業都有需求。」簡立峰再以農業為例,他曾見過企業推出利用手機拍照來判斷作物病蟲害的應用,這同樣是在裝置端完成運算的典型案例。

擁有豐富產業AI導入經驗的光禾感知科技創辦人王友光補充,小模型的能力有其邊界,擅長問答、聊天,但在深度理解或推理方面仍有限。然而,以光禾曾在電視機上盒部署小模型的經驗來看,「殺雞不用牛刀,⋯⋯在地端的應用如果只是很簡單的檢索,就用不到太大的模型。」

由於使用者需求僅限於搜尋影片、調整音量等簡單操作,小模型已綽綽有餘。「我們生活上其實不是都需要全知全能。你只要有人幫你跑腿去買個便當而已。」

AI Agent:落地需要邊緣運算支援

除了小模型,各大軟體廠商和新創公司全力投入的AI Agent(AI代理),也有望成為邊緣運算的另一大推手。

為何AI Agent和邊緣運算有關?原因在於,AI Agent能自主拆解複雜任務並規劃執行步驟,這個過程本身就會消耗鉅量的符元。

以規劃旅遊為例,Anthropic的Claude、Google的Gemini已有能力讀取螢幕內容,在使用者沒有零介入的情況下,完成搜尋景點、安排交通、預訂飯店餐廳等一系列任務。

然而,並非所有流程都能以API串接,許多環節仍需AI即時「觀看」螢幕上的資訊。黃俊達分析,若將所有運算過程都上傳至雲端,算力的消耗將極為驚人。

「我要一直把畫面串流到伺服器上,全台灣如果有一百萬人在做這件事情,就有一百萬筆上到伺服器,等於是同時看了一百萬部的YouTube(影片),大概沒有什麼網路可以撐住這件事情。」

因此,他預期未來的趨勢將是在地端先行處理資料,經過壓縮後再將關鍵資訊傳送到雲端。這正是AI Agent能夠驅動邊緣運算技術進步的核心原因。

邊緣運算發展有何限制?

儘管邊緣運算前景備受看好,但無論企業或消費者,目前仍難以完全享受到其帶來的紅利,因為軟硬體層面仍有多重關卡尚待突破。

成本高:地端模型硬體花費是負擔

從硬體來看,成本是一大挑戰。

「絕大部分還是用雲端,地端的話還是比較貴。」王友光坦言,雖然地端方案可控性高,但並非所有客戶都有預算自建機房或採購高階顯示卡,高昂的初始建置成本正是雲端方案吸引人的地方。

吳柏翰也引述Chatbot Arena平台上開放模型的排名,前幾名如智譜AI的GLM-4.5、DeepSeek-R1或者DeepSeek-V3.1,企業倘若想要在自家部署這些模型,需要至少8張、每張要價百萬出頭的NVIDIA H200顯卡,考慮成本,「台灣的企業沒辦法很快導入。」

瑞士銀行(UBS)今年曾發表報告,當中提到幾個重點,包含企業導入AI時關注投資報酬(ROI)、企業不斷進行概念驗證(POC)但沒有後續,以及因為硬體原因導致部署AI成本很高。

「這些企業需要小模型,才能把工作做好,硬撐一個超大的模型成本太高、很難落地,」吳柏翰表示,再加上金融業、製造業的資安需求,才會有前述往小模型轉向的趨勢發生。

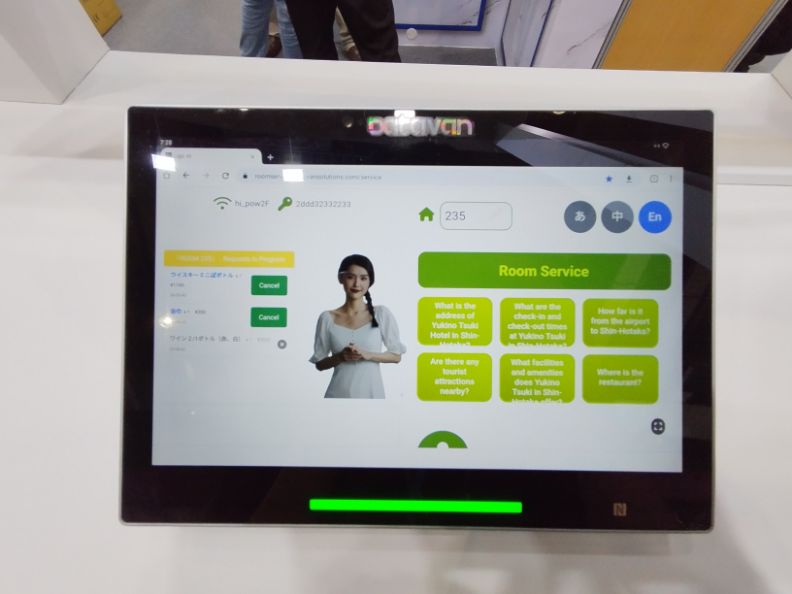

沈書緯也提到,犀動智能部署在旅宿業的智慧音箱中,真正在地端處理的僅有降噪和喚醒詞偵測等簡單任務,其餘皆在雲端完成,根本原因在於硬體性能無法承擔更複雜的工作。「1個Billion(的小模型)可能跑得動,但是沒辦法滿足客人需求。」

在同等價位下,現有硬體尚無法運行規模足夠大的模型。換言之,軟硬體各自發展還沒辦法互相契合。

軟硬體沒到位:模型不夠小、記憶體和頻寬有限

黃俊達分析,無論是AI PC或AI手機,記憶體容量不足、資料傳輸頻寬不夠、NPU算力相較於GPU仍有差距、以及運算時的功耗過高,這些都是實現裝置端AI理想的絆腳石。

他回憶起參與Google駐點科學家計畫時,與Google工程團隊的深入探討,「反正就是兩件事,一個就是增加硬體計算量的供給,另外一個就是減少需求量。」

正因目前運算效率不足,才需要更高價的硬體來滿足需求。若無法負擔硬體成本,便只能暫時依賴雲端運算。可以說,軟硬體整合不夠,再加上現階段硬體成本過高,是問題的一體兩面。

黃俊達表示,解決之道必須雙管齊下:一方面要持續改良硬體設計以加速運算,另一方面則需不斷改進深度學習演算法以適應硬體限制。「(模型開發商)如果可以把模型大小砍成四分之一、五分之一,我再把硬體的效率往上提兩倍、三倍,乘起來最後就能夠讓這件事情在地端成真。」

當軟硬體能完美協作時,普羅大眾都能享受到AI便利的理想生活,也就不遠了。

如何決定選擇邊緣運算,還是雲端運算?

在邊緣運算需求浮現、但軟硬體生態尚未完全成熟的過渡期,企業該如何抉擇?是擁抱雲端、堅守地端,還是採用混合式AI(Hybrid AI)方案?

王友光建議,企業決策者可從任務複雜度與同時服務人數(concurrent users)這兩個指標著手。前者用於估算完成任務時,單位時間內大致需要的符元數量,再乘以後者,便能推算出運行地端方案所需的硬體規格。若預算有限,上雲仍是務實的選擇。

黃俊達則認為,儘管混合式AI的概念已相當普及,但實務上受限於地端算力不足,他觀察到的現況是:「地端能算的就丟到地端算,地端不能算的你就只能丟到雲端,目前沒有其他解法。」

事實上,即使在雲端運算,只要任務設計得當,使用者也幾乎感受不到延遲。以ChatGPT為例,每次問答的資料量約數百位元組,傳輸到伺服器再接收回覆,幾乎在轉瞬之間完成,「考慮網路傳輸、頻寬需求,這個切點就切得非常好,」黃俊達說道。

邊緣運算的未來與潛在問題?

展望未來,邊緣運算的發展路徑上,企業級應用普及的速度預期將快於消費級市場。

邊緣AI好處不夠:消費者無感

由於企業面臨更多隱私保護和離線操作的需求,其採用邊緣運算的動機更為強烈。然而,對於一般消費者而言,裝置端AI的優勢卻不那麼顯而易見。

簡立峰直言,若要說服消費者支付額外費用購買AI PC或AI手機,就必須提供雲端運算所沒有的獨特回報。他認為,雲端模型不僅更強大,能力也更通用,對於常見的對話任務,一般民眾並無迫切的邊緣AI需求。「行銷上會講比較個人化、資料有隱私,但是消費者真的在乎嗎?」

深入探究,可能只有自動駕駛等極少數場景對邊緣AI有剛性需求。在殺手級應用缺席的情況下,消費者自然無感。

再以近期最吸睛的生成式AI功能來看,圖像和影片生成無疑最引人注目。但這類任務對算力要求極高,一般規格的裝置根本無法負擔,唯有雲端才能提供足夠的火力。「什麼東西一定要在地端用你的晶片處理,而不是雲端?」簡立峰認為,答案並不是太多。

突破點:等待AI殺手級應用出現

當然,這不代表消費性電子產品毫無機會。

簡立峰判斷,未來若有業者開發出極具吸引力的AI應用,且該應用在雲端運行會消耗巨額成本時,業者便會產生將部分運算轉移至地端的動機,目的就是「希望邊緣端能幫忙省錢。」

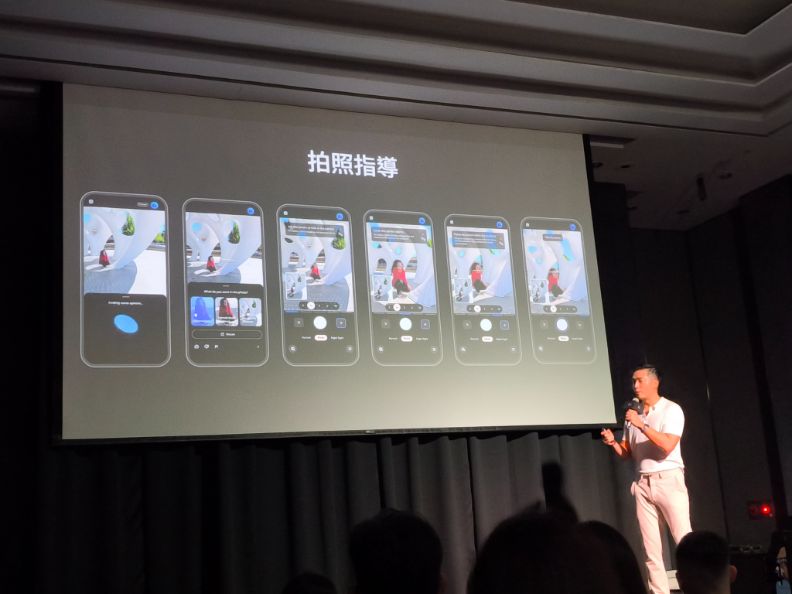

因此,最終的突破口,仍有待AI手機和筆電的開發者們找到真正契合的應用場景,例如在遊戲中嵌入更智慧的AI NPC,或讓相機的AI功能再次進化,才有可能真正點燃消費者端的邊緣運算市場。

邊緣運算的未來,不在於取代雲端,而在於與其共舞。對企業而言,這是一場成本、效率與資安的精密權衡;對消費者來說,則還在等待殺手級應用出現。這場從雲端到地表的AI革命,就看誰能最快弭平軟硬體的鴻溝、真正解決使用者的痛點,便能在這片新藍海中,搶得先機。