2024/5/14編按:OpenAI新發表會,推GPT-4o再度震驚全球!不過現場上台示範的Mark Chen,對答落落大方、讓人更感驚艷。原來他是在台灣長大後赴美,現任職OpenAI要職,中文名陳信翰。母親是清大教授、父親則曾任職光電業要職,他究竟如何從小培養超強數理能耐,獲得奧特曼青睞?其實,去年他就曾在台灣活動中,暢談自己成長背景。

台北時間5月14日,OpenAI新發表會,上台的團隊中,有一位亞洲面孔Mark Chen。他面對全球注目,示範如何對GPT-4o(omni縮寫)表演深呼吸。雖笑說自己緊張,其實舉手投足間充滿自信,讓網友倍感驚艷。

影/OpenAI新發表會上,Mark Chen示範如何對GPT-4o(omni縮寫)表演深呼吸。

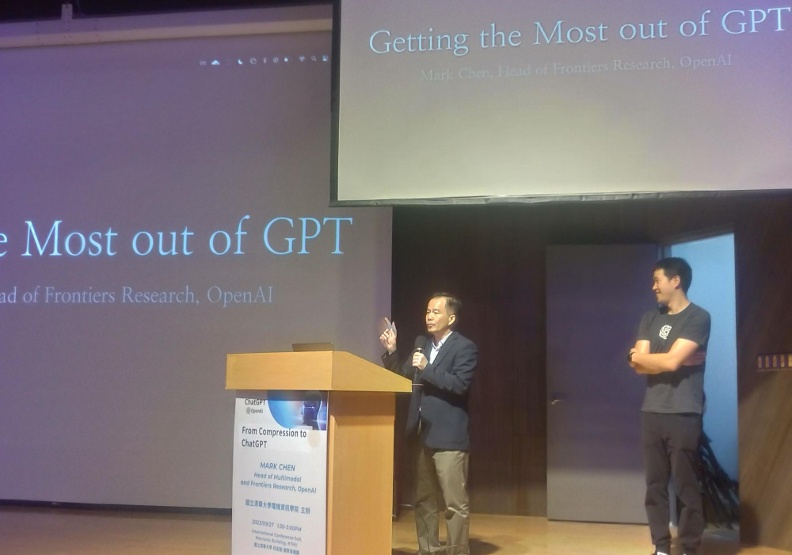

其實,這位也曾被OpenAI創辦人奧特曼(Sam Altman)盛讚的Mark Chen,正來自台灣。目前身為OpenAI多模態與尖端研究部門主管(head of multimodal and frontier research),去年9月也曾受邀至國立清華大學電機資訊學院演講。他的出身背景為何?

誰是Mark Chen?

Mark Chen的中文名字是陳信翰,他的母親邱瀞德為清華大學教授、現任資訊系統與應用研究所所長,父親陳建任曾任聯亞光電董事長。陳信翰在美國出生成長,高中時隨家人返台讀書,就讀新竹實中雙語部。

清大電資學院院長徐碩鴻分享,陳信翰高中曾到清大先修包含離散數學在內的課程。這並非清大資應所首次邀請他進行交流,2021年陳信翰就曾以「Generating Text and Images with GPT」為題線上分享。

去年在台灣的人工智慧論壇上,主持人曾問陳信翰,台灣和美國教育有何差異?他委婉表示,自己在台灣並非一個有紀律(disciplined)的學生。事實上,陳信翰接連在數學競賽AMC10、AMC12和AIME拿下滿分的好成績,因此進入麻省理工學院就讀。2008年因為AMC12接受採訪時他曾表示,「台灣的課本和試題都太強調演算,會磨損學生享受數學的樂趣。」

在MIT拿到數學和資工雙學位、在學時曾在微軟實習,陳信翰畢業後進入自營交易機構從事量化投資,開發股票和期貨的機器學習演算法,目前則在OpenAI擔任研究科學家,領導多模態與尖端研究部門,他對Codex、GPT-3、Image GPT都有貢獻,曾帶領DALLE2團隊,並且替GPT4引進視覺功能。

這場長達90分鐘的分享吸引超過400名觀眾參加,不僅座無虛席,走道上也有學生或坐或臥,陳信翰先以「Getting the Most out of GPT」演講,並隨後回答觀眾提問。

GPT-4o模型進步史,就是智力成長史

陳信翰表示,「GPT模型愈來愈像人類,」接著以模型版本迭代詳細說明。他指出GPT模型的本質為機率模型,利用機器學習方法預測新詞彙、藉此完成語句。當GPT-2出現時,即便沒有訓練模型完成特定任務,但模型卻能夠完成所有語言描述的任務。

陳信翰強調,GPT-2讓OpenAI發現「幾乎所有任務都能用語言描述」,這為何重要?關鍵在於,這個頓悟讓OpenAI體會到可以將任務化為「prompt」(指令、提示),日後藉此調校並改善模型。

進展到GPT-3,帶給OpenAI兩則啟示,其一為規模的重要性,體現出縮放定律(scaling laws)不會騙人。OpenAI曾在2020年發表論文,指出當自回歸生成式模型的模型規模增長、使用更多算力時,表現將會進步,且幅度還能用精確公式預測。陳信翰表示,「我們將會盡可能地追逐這個定律,希望它不會失效(break)。」

第二則啟示則是,只要提供足夠脈絡和實例,GPT-3就能從中學習如何完成訓練時未曾見過的任務,逐漸能夠達成人類推理時,利用歸納法做到的一般化(generalization)。快轉至今年發表的GPT-4,則引入視覺輸入(visual input)的多模態功能,且更會推理、對語言理解加深,例如能夠解釋笑話的笑點何在,這和人類對話時可以脈絡化(contextualize)的理解相同。

陳信翰盤點GPT隨版本變化的「成長歷程」,從完成句子到用指令對話,再逐步學會歸納法、理解脈絡,儘管運作方式與人類有歧異,但觀察起來有如幼童成長。

對齊模型與人類、好模型標準多元

另外,陳信翰也分享GPT的兩大挑戰:先要對齊模型行為與人類意圖,再來則想讓模型變得更「好」。

陳信翰指出,語言模型設計用途是用來預測下個詞彙,而非「對人有幫助」,因此初期的模型產出很難滿足需求。對此OpenAI的解法是「人類回饋強化學習」(RLHF),以回饋模型(reward model)讓GPT知道並模仿人類偏好。

知曉人類意圖以後,模型還能怎麼改善?首先要定義「什麼是更好」,「更好」本身就有著多重意涵,其中有三層:

1. 「讓模型運作更像人類」是一種進步,因此OpenAI有在關注「思維連鎖」(chain of thought)研究,要求模型不要直接回答問題,而要模仿人類思考時的分拆步驟,也透過互相辯論對抗,避免生成內容只有單極聲音。

2. 「讓模型回答更能驗證」也是一種進步,這點則可以用外部網頁爬蟲和自我監督處理,請開發商進駐提供外掛,直接和即時資訊對接。

3. 「讓模型回答更多元」當然也是一種進步,因此OpenAI有在考慮多元化提供人類回饋者的背景,藉此反映不同族群的想法與偏好,跟著帶動生成內容的方向。

在問答環節,陳信翰針對模型信任與安全性、OpenAI拒絕開源給出回應,也分享未來研究發展方向。

就模型信任與安全性而言,消極層次能做到的是事前預防,例如直接禁止兒童性剝削的關鍵字,其餘有爭議的詞彙則以人類回饋反制;積極層面則是更積極探究模型如何思考,並且讓模型勇於說「我不知道」,再透過外部資訊檢索補足缺陷。

針對沒有開源GPT-4,陳信翰則解釋貿然開源反而會讓人惡用,因此先開放給一般用戶使用、理解缺陷後,日後才會視情況開源,陳信翰強調安全性無法在真空中達到,意指唯有人們在真實世界試用,研究者才能理解最先進技術的限制與不足。不過,OpenAI不開源的理由,仍然無法被國際科技社群廣泛接受。

至於未來研究方向,讓模型變得更輕量化、甚至在手機上也能用,還有增加模型與真實世界的互動表現,並測試多模態模型的邊界,以及讓模型可以完成廣泛目標(general purpose),OpenAI都有在投入進行。

奧特曼和陳信翰等人,正在帶領OpenAI不斷推進機器智能,直至新的疆界。我們在旁一同見證,同時期待與擔憂,並且不懈地反思人類的價值。