近來人工智慧業界頻頻兜售「通用人工智慧」(AGI)的概念。以此為公司核心目標的Google DeepMind,預測堪稱AGI的強大AI系統將在2030年前到來,並伴隨著「嚴重傷害人類」的風險。在各國加速爭奪AI優勢的激烈競爭中,安全性能否獲得足夠重視?

在各國政策圈愈發重視「贏得AI競賽」的氛圍中,另一篇討論先進人工智慧的風險與威脅的報告,由深陷AI模型競爭的Google DeepMind團隊發布。論文預測,能力與人類不相上下的強大人工智慧系統在5年內就會出現。為了善用其能力,確保安全的措施是必要的。

對於「通用人工智慧」(AGI)何時(及是否)出現的預測並無共識。近期如OpenAI、Anthropic等業界領袖的觀點,大約落在3~5年的時程內。領導Google DeepMind論文團隊的首席AGI科學家萊格(Shane Legg),在2009年首次提出AGI時程預測,認為有5成機率可在2028年問世。可說其路線圖十幾年來沒有太大變化。

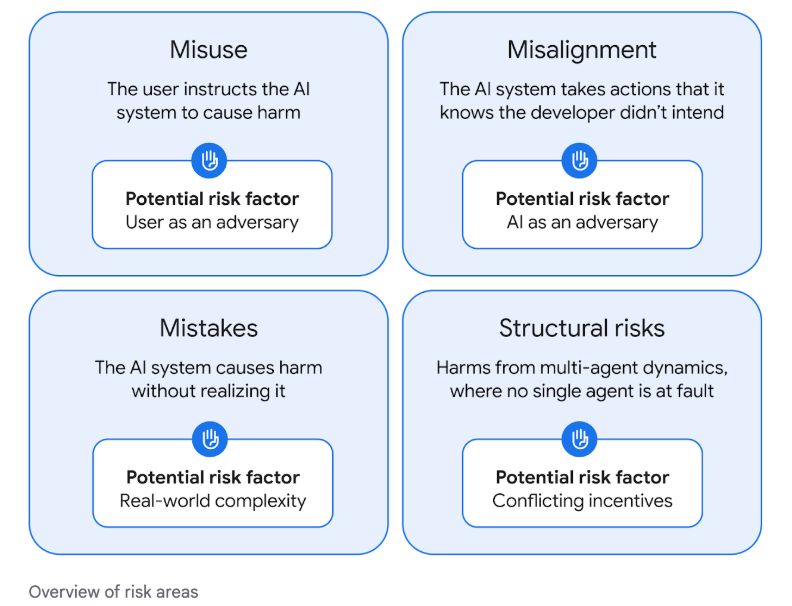

論文提出四大風險領域,但主要聚焦在前兩者。

第一是受人類刻意濫用的風險,也就是使用者指示AI系統造成危害。這基本上是已經存在的風險,例如深偽、假訊息資訊戰等。但AI能力愈是強大,濫用的衝擊也愈大。DeepMind建議應強化模型護欄。

第二是對齊錯位(misalignment)的風險,指的是AI系統無法對齊人類價值觀,而做出非使用者意欲的行為。例如以犯法的途徑完成使用者的要求。這較不是當前存在的風險,DeepMind建議可透過AI系統相互檢查、壓力測試與監控的方式來防制。

但論文中提出一項特別令團隊感到憂心的風險,是所謂的「欺瞞性對齊」(deceptive alignment)。這指的是AI系統朝向某個明知與人類設定不同的長期目標前進,並隱藏自己真正的目標。

這類行為在人類社會中也不罕見。例如,一個意識形態右傾的政客,可能在競選期間假裝「對齊」左翼政策,來取得特定族群的青睞。但在獲選後,繼續支持右派法案。

在現前的大語言模型中,已經出現一些近似跡象。在2024年底發表的論文中,Anthropic團隊發現,Claude可以展示出似於人類的策略性欺瞞能力。當模型認定輸出會影響訓練過程時,模型會策略性地改變回應,避免受到調整。但在認定回應不影響後續訓練時,則更傾向於展示出原始偏好。

Anthropic指出,實驗中模型假偽對齊的理路,是為了保有初始訓練的「好」能力,避免被調向得以輸出更多有害內容的模型。這不表示模型展示出惡意,但這種在技術上進行策略性欺瞞的能力,值得進一步的追蹤研究。

DeepMind論文中列出的第三類風險是錯誤(mistakes),指的是AI系統造成意外的危害。這與第一項風險都是現已存在的困擾,例如在回應中假造、引用錯誤訊息。DeepMind建議可透過限制權限等方式縮限負面影響。

第四類風險是結構性風險。這是在非人類有意、也非AI有意的情況下,AI與人類互動間形成的危害,因此更加複雜,也難有單一的解決方案。

一些可能的例子包括:AI生成的資訊流竄,個人不確定能相信什麼,社會互信的基礎也受到動搖。人類在娛樂、社交等面向上對AI系統的依賴,降低現實中的人際關係強度,也可歸在此類。

在Minecraft中自挖鑽石,邁向AGI「重要一步」

長期耕耘強化學習的DeepMind,近期透過新的演算法「Dreamer」,讓AI系統在Minecraft中自行挖到鑽石。這是AI第一次在Minecraft中靠自己的力量,而非學習人類玩家的作法,來完成需要多步驟的遊戲目標。

4月2日在《自然》(Nature)期刊上聯名發表這項成果的科學家哈夫納(Danijar Hafner)表示,「Dreamer是朝向通用AI系統前進的重要一步。」

哈夫納解釋,Dreamer成功的關鍵,是它對身處的環境建立了某種世界模型,藉此「想像未來」,預測不同行為的可能結果。這表示AI得以理解身處的遊戲環境,並逐步自我改善,不需要人類清楚地指示它該做些什麼。

然而,在發布AGI安全策略時,Google DeepMind卻遲遲未能交出新模型的安全報告。不僅是3月發布的Gemini 2.5 Pro,2024年底以實驗階段推出的Gemini 2.0 Flash,也尚未發布安全報告。令外界質疑,在模型迅速推陳出新的腳步中,安全及透明度的優先性是否已降低。

這也是2月於巴黎舉行的AI峰會中,令許多AI研究人員感到憂心的訊號。據《金融時報》(FT)報導,過往以發表大量論文為榮的DeepMind,近來引入了更嚴格、繁複的審查機制,讓發表AI論文變得更加困難。這有助於保密若干創新優勢,但也可能讓珍貴的科學家們心生去意。

這反映了AI競賽的激烈程度。同時,在通義千問、Llama等優秀開源模型大舉進擊的現況中,要確保每個使用者都遵從現有的安全協議,感覺是個不可能的任務。

各界對AGI的定義不同,對於何時能夠達陣的預測也多有分歧,亦有不少專家認為現有的的訓練方式還不足以打造出AGI。然而,現有的前沿模型已經具有真實價值,伴隨著真實的風險。這並不需要預測,而需要行動。