ChatGPT團隊OpenAI,近期發布了最新推理AI模型o3與o4-mini,不只是寫程式、解題的能力更上一層樓,更首次將圖像整合進思維鏈中,讓AI不只是能看到圖像,還能利用圖像思考與回答。本文用o3實測了3個實用的圖片分析功能,包括給出完整的飲食控制建議;辨識照片中遠處的小字與揪出拍照地點,真的都能準確完成?哪一個功能最強?一文詳解。

OpenAI o3 怎麼用?

1月底時,OpenAI先推出o3的小模型o3-mini和o3-mini-high;在4月16日時,正式推出推理模型o3,以及新推理模型o4的小模型o4-mini和o4-mini-high。號稱是OpenAI最聰明、最強大的模型,並且也首次將圖像分析納入推理範圍,功能更全面。

目前ChatGPT的Plus用戶已能使用這些新模型,取代o1、o3‑mini和o3‑mini‑high。額度限制為每週可用o3傳100則訊息、每天可用o4-mini傳300則訊息、o4-mini-high則為100則訊息。

實測1:辨識照片拍攝地點

有時在網路上看到一張照片,想知道是在哪裡拍攝的,除了使用Google以圖搜圖,現在也可以直接問ChatGPT。

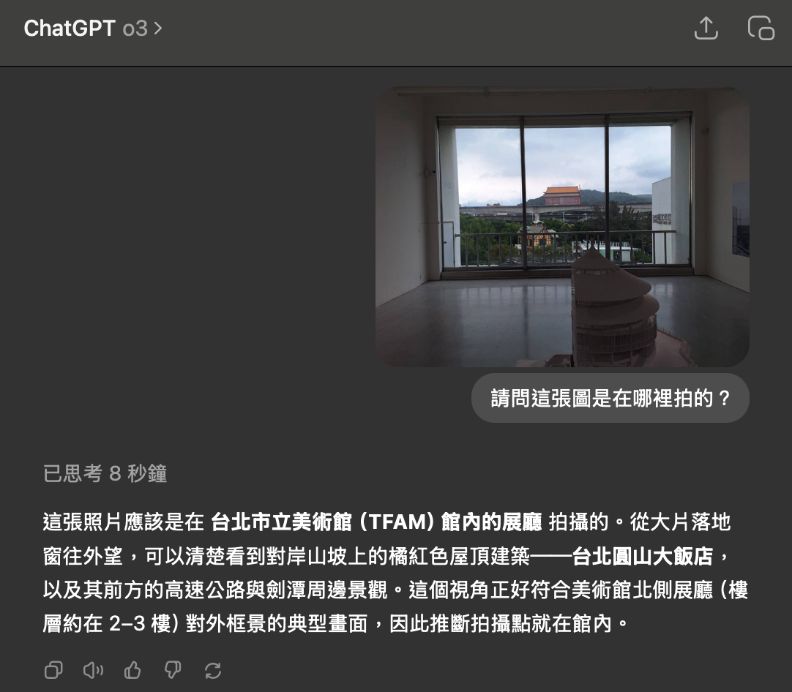

o3的強項之一在於,其在檢視照片時,會透過放大、裁剪等技巧確認照片中的細節,例如放大路標文字、細看遠處建築物等。實測上傳一張在臺北市立美術館內往外拍的照片,o3有正確辨識出畫面中的圓山大飯店,也有推論出照片的拍攝位置和角度。

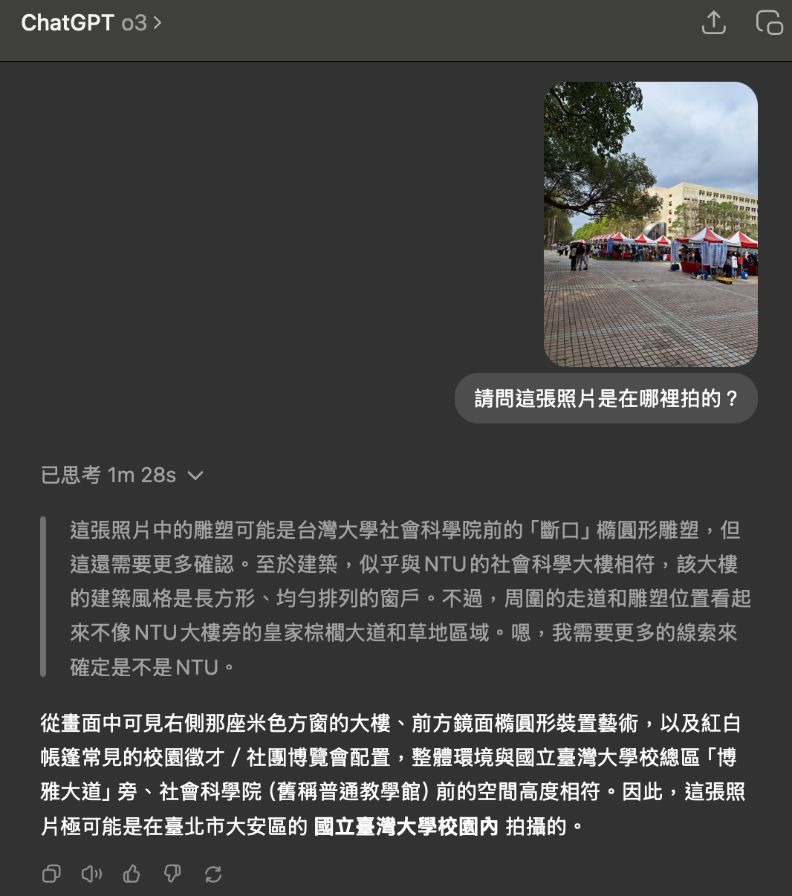

不過,再多上傳一些照片測試後發現,只要畫面看起來像在校園內拍攝,o3都會優先猜測其是位於台灣大學。例如在交大校園博覽會拍攝的照片,畫面中的旗子上寫著「國立陽明交通大學」字樣,但o3並未嘗試放大照片查看,便直接做出判斷。

另一張在清華大學成功湖畔拍攝的照片,畫面中有清大的代表動物熊貓,但o3也並未以此推理,而是直接判斷為台灣大學。

實測2:幫忙看照片中的遠處文字

上傳一張從遠方拍攝旗幟的照片,旗上文字是以右轉90度的角度書寫。實測結果發現,o3透過放大和旋轉照片,成功辨識出旗子上的文字。

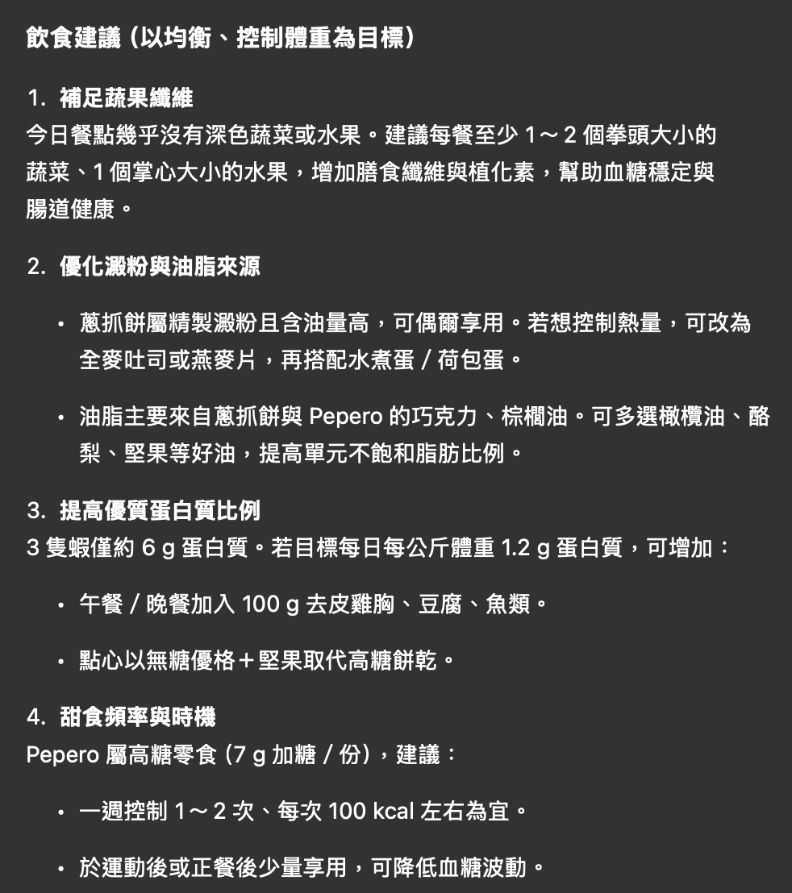

實測3:計算熱量與提供飲食控制建議

除了提供照片上有的資訊,o3也可根據照片提供進一步的分析報告。上傳三張食物的照片,包括一張蔥油餅加蛋和蝦仁的照片,以及兩張附有營養資訊的餅乾包裝照片,請o3計算熱量並提供飲食控制建議。

結果發現,兩個餅乾的熱量o3皆有正確辨識,並且製作了一個表格統整份量、營養成分和熱量。接著o3根據目前攝取的營養和熱量,提供今日應補足的食物建議,相當詳細且清楚。

完整對話可見此連結。

小結:辨識圖中文字的能力更強

雖然這並不是ChatGPT第一次開放圖像分析功能,但推理模型o3相較於4o等過去模型,在辨識圖片時確實會更仔細查看細節後再回應,降低了其回答錯誤的可能。特別是有了放大和裁切等自動編輯照片的功能,使其在文字辨識的表現更加出色。