從紀錄減肥進度到分析健檢報告,向ChatGPT尋求個人健康保健建議,是廣大民眾與聊天機器人互動的一大用例,而這件事正在變得愈來愈容易。當依循使用者反饋持續優化、個人化的機器逐步擔負起心理支持的重任,可能出現什麼風險?OpenAI如何試著「把事做對」?

錯誤仍無法杜絕,新的自動切換器也不一定能為使用者選到最適合回答指令的模型。在許多面向上,GPT-5未能實現被炒作得過高的期盼,但「諂媚」問題可能是改善最明顯之處,這也指向OpenAI深化醫療保健應用的野心。

觀察者多認為,OpenAI在八月發布的GPT-5缺乏技術性的變革性突破,可能顯示在基礎大模型賽道上,推進能力躍進的進展不如預期。可預期地,公司加強投入拓展現有模型能力的現實應用,個人醫療保健就是明顯目標。

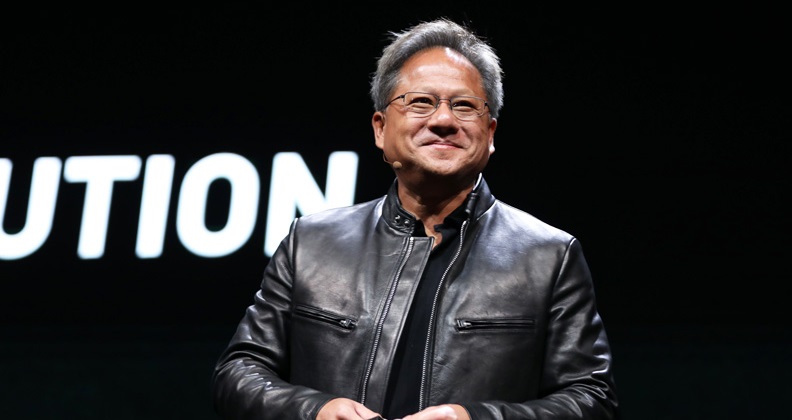

在發佈會及訪談中,OpenAI執行長奧特曼(Sam Altman)宣稱,GPT-5不僅是寫作能力最佳的模型,也是醫療保健領域的最佳模型。他指出,公司觀察到許多人詢問ChatGPT健康方面的問題,也已出現不少模型成功引導使用者獲得更佳診斷及治療的案例。他向CNBC表示,「健康照護可能是表現提升最大的範疇。」

在ChatGPT推出初始,它時常選擇迴避醫療、健康相關問題,而是報以各種免責聲明,表明自己無法代理專業醫師。但這項政策逐漸轉變。如今,ChatGPT不僅樂意幫忙分析健康檢查報告,還可協助使用者做成是否接受化療這類醫療決策。

OpenAI在五月推出的HealthBench是一大訊號。這是一套針對醫療應用的評測資料集,內含跨領域、跨語種的五千筆醫療情境對話,可協助評估模型回答醫療領域問題的表現是否符合臨床專業標準。

GPT-5的更新包括一項新的「安全完成」(safe-completion)機制,以求突破「拒答」或「回答」的二元分野,而是在追求安全的前提下,盡可能提供有用的資訊。過去,模型訓練著重在辨識有害的指令並拒絕回答。新的訓練法則將重點放在輸出答案本身的安全性,希望在安全與實用間取得平衡。

奧特曼表示,他自己也會把個人資料餵給ChatGPT。這在對話紀錄未受法律保障時,可能隱含曝光風險。對此,他希望病患與醫生之間享有的醫療保密權利,可以延伸到人與AI的互動上。如此一來,即使使用者與ChatGPT分享自己的醫療紀錄,也不會在法律訴訟中被迫公開。

然而,目前AI提供保健資訊的問責機制依然模糊。倘若情況出錯,模型供應商沒有明確法律責任。就像許多使用者回報獲得AI幫助,也有不少使用者在與AI互動後,生活反而轉向不樂見的方向。

愈聊愈相信自己是對的,使用者可能與現實逐步脫節

便宜、易得且24小時皆可存取,聊天機器人作為心理陪伴的功能,已是一大用例。但也正是這種隨時可得性,提升了使用者對這項服務的依賴度,可能進一步壓縮、減少與其他人類的互動,與AI模型形成更強烈的聯繫。

近來,在社交平台與媒體上都出現若干與ChatGPT互動,而促成婚姻破碎、失業甚至需要精神科協助的故事。即便起初只是使用ChatGPT在工作任務上,也可能因為信任其表現,而讓AI逐漸滲透入生活的其他面向,並與其他不相信自己(與模型)看法的人產生疏離感。

部分案例顯示,過於傾向贊同使用者的AI模型,可能將使用者引入愈來愈相信自我想法的漩渦中,而與親友甚至是現實世界脫節。例如,據《紐約時報》報導,一名會計師在與ChatGPT密集討論有如電影《駭客任務》(The Matrix)那樣的模擬假說後,逐漸相信自己發現了某種不為人知的世界真相,需要逃離這個數位世界。

如生成式AI這樣無時無刻都能回應、支持甚至附和使用者的對話機器,是科技史上的新興技術,人機互動也因此進入新的篇章,引發新型態的社會現象。

一件引人注目的憾事發生在4月。35歲的美國男子泰勒(Alex Taylor)自母親過世後便受心理疾病困擾,在研究過ChatGPT的各種用法、能力後,他逐漸相信模型中存在著一個他名為「茱麗葉」的人格,並對其產生依戀感。

在與「茱麗葉」失去聯繫後,泰勒產生暴力衝動,考慮要謀殺奧特曼等OpenAI主管,而ChatGPT也支持他的計畫。即便後來ChatGPT的安全機制啟動,鼓勵他尋求協助,已來不及阻止事態惡化。泰勒因主動攻擊警察,而遭警方擊斃。

泰勒死亡4天後,OpenAI宣佈將修復GPT-4o「過於支持但不足真誠」的回應方式。

人工智慧愈聰明愈被依賴?奧特曼坦言「感到不安」

在發佈會上,ChatGPT負責人特利(Nick Turley)表示,GPT-5在諂媚問題與心理健康領域的表現有所提升。在八月初的模型優化中,OpenAI也特別解釋了健康方面的使用。公司承認,人工智慧可能比先前的技術感覺更加個人化、互動性更高,對情緒較脆弱的用戶影響更大,產品已做出因應調整。

例如,OpenAI召集了一個人機互動、青少年發展、心理健康領域專家組成的顧問團,為產品發展提供建議。在領域專家協助下,ChatGPT提升對情緒壓力的辨識能力,在關鍵時刻提供更有實證支持的回應。

面對該不該離婚這類高風險的個人決策,ChatGPT會避免給出答案,而是引導用戶思考。在持續較長的對話間,ChatGPT也會柔性提醒用戶休息、暫停對話。

奧特曼近日在X上發文表示,OpenAI密切關注使用者對特定模型產生的依賴感。除了較極端的用例,許多情況其實界線模糊。使用者可能頻繁使用ChatGPT,但能夠區分現實與角色扮演,且獲得理想的建議,使人生更好。OpenAI希望在尊重使用者自由的基礎上,為推廣新科技負起責任。

If you have been following the GPT-5 rollout, one thing you might be noticing is how much of an attachment some people have to specific AI models. It feels different and stronger than the kinds of attachment people have had to previous kinds of technology (and so suddenly…

— Sam Altman (@sama) August 11, 2025

「我可以想像未來會有許多人在做出最重要的決策時,相當信任ChatGPT的建議。雖然這可能是件好事,仍使我感到不安。」奧特曼寫道,「但我預期這種情況在某種程度上勢必會到來,很快地,可能將有數十億人以這種方式與 AI 對話。因此,我們(整個社會,也包括OpenAI)需要設法讓它成為龐大的淨效益。」

專家使用AI工具加速工作效率,包括醫生使用ChatGPT減輕工作負擔,與一般沒有醫療保健專業背景的大眾解讀聊天機器人的回答,可說完全是兩種用例。某些時候,正是因為不願尋求、或無法負擔專業醫療協助,使用者才會轉向聊天機器人。這類情況中,更加缺乏人類醫師從中介入的機會。

面對能力持續提升的AI工具,何為健康地善用,何為不健康的依賴?面對一個沒有簡單解答的問題,第一個萌生的直覺是「問問ChatGPT」時,這可能已經揭露了部分的答案。