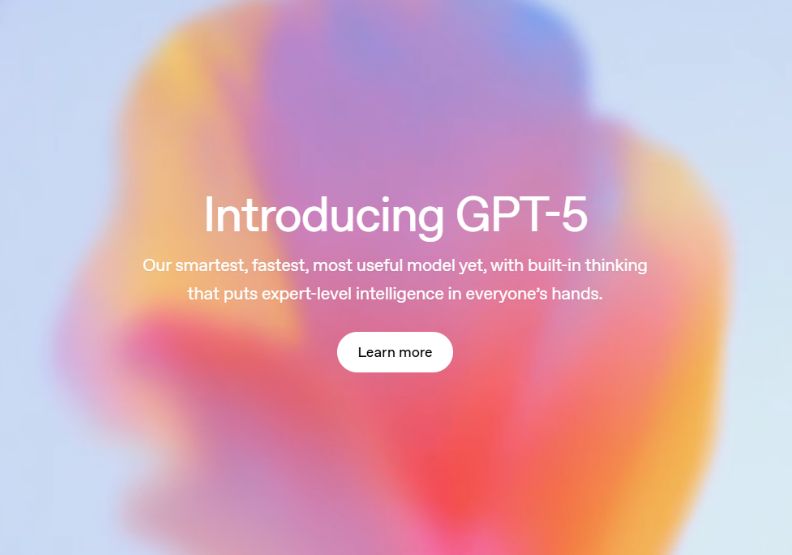

根據OpenAI最新釋出的技術文件,即便進入GPT-5時代,下對指令仍有必要。ChatGPT模型不斷進步,從GPT-3.5、GPT-4.0,再一路到GPT-4o、有推理能力的o3、o4,甚至還有輕量、主打回覆速度快速的mini系列模型。當模型變得更加聰明,我們還需要謹小慎微地寫指令嗎?近期社群上有人認為「指令已死」,沒必要認真研究指令工程,引起網友熱議。到底OpenAI官方為何堅持一個好指令很重要?好指令的標準在哪?必學的「元提示」又是什麼?為何這個簡單動作能大大提升指令品質?請見來自官方的完整建議。

當語言模型掌握推理能力,可以自行拆解使用者指令,規劃出完整計畫時,社群上開始出現「指令已死」的聲音。

不過,攤開OpenAI釋出的「GPT-5 指令指南」,可以看到,下好指令、追尋指令工程(Prompt Engineering),對於AI產出好內容,還是有很大幫助。

因為,GPT-5依照指令行事的精確度與執行力,已達到「前所未有的水準。」這意味著,使用者與模型互動的方式,將直接決定最終成果的品質。

本文整理OpenAI這份官方文件,從中提煉出幾項下好指令的技巧,希望讓使用者在GPT-5時代,能夠更好駕馭AI。

指定角色、提供範例,過往技巧仍適用

賦予模型明確的角色

為模型設定一個清晰的身分,是引導其語氣、觀點及專業深度的有效方法。

例如,比起直接叫ChatGPT寫一篇推廣飲料的文案,指派角色的效果更好:「你是一位資深的文案專家,風格風趣,擅長用故事吸引年輕讀者。請為一款新的燕麥奶拿鐵撰寫一篇社群媒體推廣文案。」

其實,以前在社群上指派角色給ChatGPT,就曾紅極一時,在GPT-5的官方指令指南中,也沒有捨棄這個技巧。

OpenAI在三段指令中,都曾經指定官方角色,確保模型能立刻進入特定領域的工作模式。例如:

提供具體範例,不要只是給模糊的形容詞

模型不是沒辦法讀懂解主觀形容詞,例如「給我一篇專業文章」,只是如果提供具體、可量化的規則,效果更佳。

舉例來說,在生成文件時,只是要求「排版整齊」不夠,最好可提供精確的設計規範。

在GPT-5指令指南中,就有一段「程式碼設計標準」的指令,應用到這個技巧:

同樣地,在要求模型使用Markdown格式時,OpenAI所下的指令不只是「請用Markdown」,而是提供清晰的規則與範例,讓ChatGPT知道應該何時調整格式。

引導模型進行分好幾個步驟思考

面對複雜任務,強迫模型一步到位往往會犧牲品質,更有效的方式是引導其先進行規劃與推理,官方文件中也反覆強調這個概念。

例如,在開發一項新應用時,OpenAI沒有直接要求成果,而是要求模型分好幾個步驟:

雖然模型有能力自己制訂計畫,但如果預先準備好更詳細的步驟,可以讓模型行動更貼近預期。

在調用外部工具前,GPT-5文件中也建議要求模型先「列出一個結構化的計畫,詳細說明將採取的每個邏輯步驟」,以確保行動的準確性。

精準調控模型的「積極度」(Agentic Eagerness)

GPT-5最顯著的進步之一,是使用者可以通過指令,精準控制模型的自主性與思考深度。OpenAI將此以調控「代理積極性」(Agentic Eagerness)描述。

提升積極度,賦予模型自主權

在進行創意發想或處理複雜專案時,使用者可以鼓勵模型採取更主動的角色,避免因不確定性而中斷任務。

文件建議使用以下指令來達成此目的:

降低積極度,追求效率與速度

當任務目標是快速獲取資訊時,使用者可以主動限制模型的思考範圍,以換取更快的反應速度:

過往使用者會先評估自己的目標,例如要求回覆速度超快,或者期待回覆品質極高,再藉著挑選模型的方式實現。

現在,使用者則是在指令中寫清楚期待,讓模型依照指令行事。

讓AI自己改善指令,但要注意矛盾

模型能力提升,讓生成內容品質提升,甚至可以讓AI幫忙調整指令,但也要小心避免矛盾。

利用模型進行「元提示」(Metaprompting)

當使用者對輸出結果不滿意時,可以直接請求模型本身協助改善指令。這形成了一個強大的自我修正迴圈。官方文件提供了一個有效的模板:

避開致命錯誤:指令的內部矛盾

GPT-5對指令的精準遵循是一把雙面刃。如果指令內部存在邏輯矛盾,模型不會像過去一樣忽略,而是會陷入困惑,反而讓生成內容的品質下降。

在指南中的這個範例裡面,OpenAI如實呈現出風險:

這種指令會讓模型無所適從。那麼應該如何解決呢?OpenAI指出,好的指令應該明確定義例外情況,以解決衝突:

使用者在設計複雜指令時,一定要審視內部邏輯的一致性,避免出現矛盾。

雖然進入GPT-5時代,使用者不再需要選擇模型,已經有內建的模型挑選器,導引到合適的模型,但指令工程仍有其價值。

明確設定角色、以範例消除模糊、引導模型先規劃後行動、靈活調整積極度,以及善用「元提示」,都是專業使用者不可或缺的技巧。