AI人工智慧風潮熱,爭議也多。紅遍大街小巷的ChatGPT,在微軟將其整合進搜尋引擎Bing、OpenAI開放ChatGPT的API之後,聲勢更熾。不過,雖然ChatGPT陸續釋出新版本補上破洞,但使用者仍不時發現AI竟也會信口雌黃、憑空捏造。

對此,OpenAI怎麼處理?

除了令人詬病的捏造答案以外,使用者玩弄ChatGPT的「越獄」(jailbreaking)行為也廣受關注。雖然OpenAI有設定ChatGPT不應該回答的話題,例如涉及性犯罪與暴力、種族議題、製作武器等,但使用者可以設法引導繞過此項限制,例如以撰寫小說的名義,請ChatGPT回答,這個行為就是「越獄」。

AI也會捏造、越獄、立場偏見,三大問題有待克服

OpenAI上個月在官方部落格當中發布一篇名為「人工智慧系統應該如何表現,又有哪些人有權決定(哪些表現式對的)」的文章,文中提到,OpenAI的關鍵任務是開發出能夠造福全人類的通用型人工智慧,在此前提之下,它們希望可以讓AI系統如ChatGPT貼合人類的價值。

不過,OpenAI坦承,現階段的ChatGPT,在產出上有著諸多不足,有些模型生成的內容具有政治偏見、會冒犯人,甚至令人反感。

舉例來說,美國保守派媒體《福斯新聞網(Fox News)》就曾經報導,有用戶指控ChatGPT立場傾向自由派。

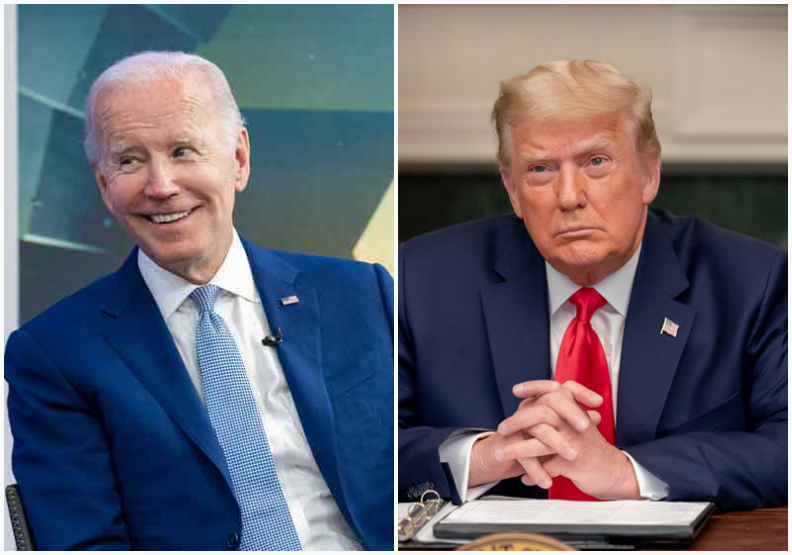

這也體現在ChatGPT產出的內容上,雖然OpenAI訂有規範,要求ChatGPT不要回答涉及政治理念分歧的相關問題,就有使用者發現ChatGPT拒絕撰寫讚頌川普(Donald Trump)的詩,但卻願意譜寫關於拜登(Joe Biden)的讚詩*。

雖然ChatGPT與人們對答的行雲流水,讓生成式AI成功站上大眾關注的風口浪尖,但原地瞎掰的捏造問題、使用者繞過限制的「越獄」問題、回答有立場的偏見問題,這三個ChatGPT尚未克服的問題,有待OpenAI應對。

技術驅動、回溯訓練資料源頭、推客製化模型,OpenAI三招改進

《麻省理工科技評論》訪問了兩位OpenAI研究人工智慧政策的研究員,兩位研究員針對上述問題,提出OpenAI的改進之道。

AI會從「以上皆非」選項中,硬選答案

首先,針對捏造問題,OpenAI從技術著手,將使用者的回饋用來改善強化學習,減少模型虛構的比例。不過,無法做到完全遏止虛構,因為演算法的原理是從資料中挑選較佳的選擇,因此模型可能會從「以上皆非」的內容中,挑選不那麼糟糕的其一,但仍是錯。因此OpenAI另外投入資源於清理資料,從源頭清理做起,冀望能減少上述情況發生。

為了應對使用者劫獄、誘導ChatGPT的不當行為,OpenAI則先採取治標辦法,蒐集了引誘的命令,提前制定規則防止ChatGPT受欺騙;OpenAI也在尋求意見,討論到底該禁止、開放哪些提問。不過,使用者們總是能夠想出辦法劫獄,這會是OpenAI需要持續努力的問題。

測量人們對爭議問題的回答

針對最為棘手的偏見爭議,OpenAI打算推動「共識專案」(consensus project),測量人們對於爭議問題回答的看法,以便改善品質。它們坦承,旗下聘僱的資料標記員,無法代表我們所在的廣大世界,對於「天空是否為藍色」來說科學上有清楚答案,但大家對於「徵稅是好是壞」卻有不同想法。

另外,OpenAI還有一個理想,希望能夠訓練出代表世間不同價值觀與世界觀的模型「們」,與其硬擠出一個能夠塞下所有想法的模型,OpenAI更想推出客製化的模型,如此一來,人們就不用擔心模型回答不合己意了。

針對惡意應用,還有ChatGPT不時展現出的缺陷,以及讓企業動輒得咎的意識形態傾斜,OpenAI謹慎地嘗試各個擊破。

不過,有人的地方就有江湖,江湖中一定有門派之爭,就算OpenAI能夠推出政治立場上客製化的模型,也可能會促進同溫層、鞏固既有意識形態的回聲室,這樣對於民主素養的化成來說未必是件好事。

即使是人工智慧,也沒辦法消弭惡意與戰爭,這會是人類在科技高速發展下,依舊必須面對的課題。