編按:生成式AI的競爭重心,正轉向推論成本與供給穩定度。Google以Gemini結合搜尋入口與TPU,推進算力布局,正面挑戰輝達GPU與CUDA生態。而在這場算力主導權之爭中,台灣於先進封裝、系統交付與ASIC協同設計的關鍵性,正快速升高。

生成式AI的競爭邏輯正在改變:從「誰能訓練出更強的模型」轉向「誰能以更低的推論成本、更穩定的供給,把模型部署到更大的使用場景」。當推論成為主要支出項,算力不再只是性能指標,而是成本曲線、供應鏈與生態系的綜合戰。

Gemini優勢不只在能力,而在入口的規模化分發

Google把Gemini的升級與既有產品入口綁定,形成「模型能力—產品滲透—使用回饋」的加速迴路。Alphabet在2025 年Q3執行長談話中揭露,Gemini App已超過6.5億月活躍用戶,且查詢量較Q2成長3倍。

同時,在2025年Q2的CEO說明裡,Google指出Search的AI Overviews已擴及200+ 國家與地區、40種語言,月使用者 超過20億。

這代表Gemini的競爭力不是把使用者「導流到一個AI產品」,而是把AI變成搜尋與工作流的底層能力——入口本身就是護城河。

2025年11月,Google發布Gemini 3,並在官方產品說明中指出其在LMArena以1501 Elo登頂。

路透同日報導也提到,Google將Gemini 3更深度嵌入搜尋,並推出能完成多步驟任務的「Gemini Agent」類能力,強化從「回答」走向「代辦」的產品方向。對企業用戶而言,重點不只是榜單,而是模型升級能否直接轉化為可控、可衡量的生產力提升;Google的作法是把模型、工具使用與雲端平台同時推進。

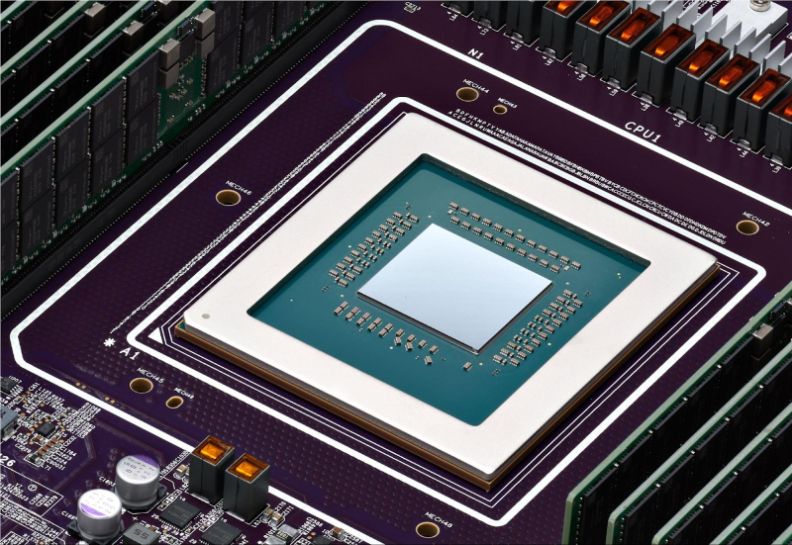

TPU Ironwood:推論時代的成本武器

硬體層面,Google在2025年4月推出第七代 TPU「Ironwood」,並明確以「推論時代」定位;官方指出其提供256與9216晶片兩種配置,支援超大規模部署。

這背後的策略很清楚:當AI的價值從「訓練一次」轉向「被大量呼叫」,能否把推論的單位成本壓下來,將直接決定雲端服務的毛利與擴張速度。TPU作為專用加速器,不必在所有工作負載上追求通用性,而是用工程化方式在關鍵負載上建立成本優勢。

TPU外溢到市場,才是Google最具破壞性的動作。2025年10月,Anthropic宣布擴大採用Google Cloud TPU,規模上看多達100萬顆TPU,並計畫在2026年帶來逾1GW的算力容量;路透亦指出其採用主因是成本與效能考量。

2025年11月,路透再報導Meta與Google洽談自2027年起在資料中心使用TPU,並可能更早透過Google Cloud租用。

一旦雲端巨頭能提供「第二條大規模算力供給」,企業在GPU採購與雲端談判上就不再只有單一路徑,市場權力結構會被鬆動。

輝達真正護城河在CUDA

輝達長期壟斷的核心不只是晶片,而是CUDA與開發工具鏈帶來的遷移成本。2025 年12月,路透揭露Google內部推動「TorchTPU」專案,目標是讓TPU更順暢支援主流PyTorch,並與PyTorch的關鍵推動者Meta形成合作動能。

這意味競爭焦點正在從「算力誰更快」,轉向「誰能把切換成本降到足以讓企業改路徑」。一旦工具鏈相容性被打通,TPU的外部擴張,才可能從少數特例變成規模化選項。

台灣不是旁觀者,而是三個「瓶頸位置」掌握者

1.先進封裝是算力供給的閥門

2025年1月,路透引述黃仁勳說法指出,輝達正從CoWoS-S轉向CoWoS-L;同時也提到先進封裝產能在不到兩年內大幅提升,但仍是瓶頸。

對台灣而言,先進封裝不再只是後段製程,而是AI晶片能否出貨的關鍵限制條件;能擴產、能升級、能維持良率,就能影響全球算力供給曲線。

2.AI伺服器與液冷:台灣ODM從製造走向系統協同設計

路透在2025年8月報導指出,台灣科技業正由消費電子轉向AI伺服器,並點名廣達、緯創等在營收上的顯著成長。TrendForce亦指出,隨GB200∕GB300機櫃出貨擴大,液冷採用率上升,資料中心需從機櫃到機房的配套設計「液冷就緒」。這使台灣的價值鏈從「代工產能」上移到「系統整合、散熱工程、交付能力」:愈靠近部署現場,愈能沉澱成長期競爭力。

3.ASIC化與共同設計:台灣開始進入雲端巨頭的晶片協作鏈

2025年3月,路透報導Google準備與台灣聯發科合作開發下一代TPU,並提及Google希望降低對輝達晶片的依賴。

這對台灣的意義是結構性的:未來算力市場不是「GPU一統」,而是「GPU+多家ASIC並存」。台灣若能把優勢延伸到共同設計、製程協同與封裝∕互連整合,就有機會在新架構競爭中取得更高附加價值的位置。

台灣戰略題!不是選邊,而是放大三個槓桿

Google以「入口分發(Gemini)+推論成本(TPU)+工具鏈相容性」推進全栈整合;輝達則以「通用GPU平台+CUDA生態」維持高度黏著。可以預期的是,未來一段時間不會出現單一勝者,而是走向多架構、多雲、多供應並存的競合格局。也因此,台灣最務實且最具上升空間的策略,不是押注單一陣營,而是把自身在全球算力供應鏈中的不可替代性,集中放大在三個決定「供給」與「交付」的瓶頸位置。

第一是先進封裝:在HBM堆疊、晶粒整合與功耗密度快速攀升的時代,封裝不再只是後段製程,而是AI晶片能否出貨、能否維持良率與能否控制成本的關鍵閥門。台灣若能在CoWoS等先進封裝的產能擴張、製程升級與良率管理上保持領先,就等同握住全球算力供給曲線的一段「開關」。

第二是系統與液冷交付:推論規模化意味著機櫃密度更高、能耗與散熱更吃緊,AI伺服器不只是「組裝」,而是從機櫃、散熱、電源到機房級部署的一體化工程;台灣ODM∕EMS若把能力延伸到整機整櫃、液冷就緒與快速交付,將更接近雲端客戶的核心決策鏈。

第三是ASIC協同設計:當雲端巨頭以TPU等ASIC對沖GPU供應與成本風險,台灣不應只停留在製造端,而應強化從架構規劃、互連與封裝協同,到量產導入的共同設計能力,讓台灣在「多ASIC時代」成為設計—製程—封裝—系統整合的樞紐。

簡言之,當AI進入推論規模化階段,真正的勝負不是單一晶片或單一模型的性能,而是成本曲線、供給可得性與交付速度。台灣若能把先進封裝、系統∕液冷交付與ASIC協同設計三個槓桿做深做寬,就不只是供應鏈的一環,而是新一輪全球算力秩序中,能影響規則與分配的關鍵節點。